Prototyp The Machine od HP już w przyszłym roku.

Prototypowa wersja futurystycznego komputera the Machine od Hewlett-Packard ma być gotowa już w przyszłym roku. Będzie przygotowana dla partnerów mających zajmować się opracowaniem odpowiedniego oprogramowania, jednak do etapu produktu końcowego brakuje jeszcze około pięciu lat.

Prototyp opcji single-rack będzie wyposażony w 2500 rdzeni oraz pamięć główną o pojemności 320TB. Według Martina Finka, dyrektora HP Labs, który podał szczegóły dotyczące superkomputera na konferencji HP Discover, to ponad 20 razy więcej niż jakikolwiek dostępny obecnie na rynku serwer.

Jest jednak jeden haczyk: prototyp będzie wykorzystywał stosowane obecnie chipy pamięci DRAM, ponieważ technologia memristor, której zastosowanie planuje firma, jest wciąż w fazie opracowania. To jeden z powodów, dla których na ostateczną wersję the Machine będziemy musieli poczekać jeszcze kilka lat.

HP stawia wiele na jedną kartę zakładając stworzenie nowego rodzaju komputera mogącego przechowywać wszystkie dane w ogromnych zasobnikach pamięci nieulotnej. Według HP, the Machine będzie przewyższał każdy współczesny komputer. Rozwiązanie wielkości lodówki będzie w stanie wykonać taką samą pracę jak całe data center.

Konkurencja drwi z planów HP wskazując ogromne wyzwanie jakim jest dostosowanie oprogramowania do nowej architektury. Dla firmy jest to jednak jedyny sposób na efektywne energetycznie poradzenie sobie z czekającymi w przyszłości ogromnymi zasobami danych.

W stosowanej obecnie architekturze serwerowej procesory stanowią centrum system, wokół których rozmieszcza się wiele warstw pamięci i storage’u, łącznie z DRAM i twardymi dyskami. Celem HP jest całkowita rezygnacja z twardych dysków i zastąpienie DRAM obszarami pamięci nieulotnej.

Taki rodzaj pamięci przechowuje dane przy wyłączonym zasilaniu, dzięki czemu the Machine będzie bardzo energooszczędna. Pamięć nieulotna istnieje już teraz, chociażby w postaci NAND Flash, jednak jej wydajność pozostawia wiele do życzenia, zwłaszcza w kontekście systemów obliczeniowych wysokiej klasy. Memristory mają być znacznie lepszym rozwiązaniem.

Mimo to, przyszłoroczny prototyp nie będzie bardzo energooszczędny. HP będzie musiało zapewnić stałe zasilenie dla DRAM tak, aby dane były cały czas dostępne dla wszystkich aplikacji. Według Finka, takie rozwiązanie będzie działać jako "proxy" dla pamięci nieulotnej, umożliwiając partnerom, takim jak SAP rozpoczęcie testów aplikacji.

W okresie przejściowym pomiędzy zastosowaniem DRAM i memristorów the Machine ma wykorzystywać pamięć nieulotną typu phase-change, będąca teraz w fazie badań.

Dla the Machine pamięć będzie częścią priorytetową, połączoną z systemem wysokiej prędkości krzemowym łączem fotonicznym, mogącym przesyłać nawet 1.2TB danych na sekundę.

"Moc the Machine będzie wynikać z umieszczenia pamięci w centrum systemu, z otaczającymi go procesorami”, powiedział Fink. Ma on też nazwę dla nowej architektury, na której bazować będzie nowy superkomputer: Memory Driven Computing.

HP jest właśnie w trakcie wielkiej debaty dotyczącej aplikacji, które mają zostać uruchomione na the Machine. Większość osób chciałaby przenieść w ramy nowej maszyny już istniejące obciążenia, co według firmy będzie możliwe. Jednak bardziej interesujące są zupełnie nowe aplikacje, niemożliwe do operowania w dzisiejszych warunkach.

Jako przykład Fink podał samolot lądujący 30 minut przed czasem, który nie może skorzystać z najbliższego wolnego gate’u, ponieważ system komputerowy lotniska nie jest na tyle „sprytny”, aby wiedzieć, że jest to możliwe.

The Machine pozwoli liniom lotniczych przechowywać wszystkie dane dotyczące każdego przylotu

i odlotu, wraz z informacjami o gate’ach, pogodzie oraz innych zmiennych. Dane dostępne będą w każdym momencie, umożliwiając ich natychmiastową analizę.

To świetna historia, jednak jak to ma miejsce z większością wielkich nowych technologii musimy poczekać jeszcze 5 lat, aby przekonać się czy wszystko ułoży się tak gładko. Jakiś czas temu Intel był przekonany, że zdobędzie świat dzięki nowej architekturze procesorów Itanium. Jak się okazuje rozwiązanie to skończyło się wielkim niepowodzeniem.

Mimo obaw, HP trzyma się założonego planu. Na konferencji HP Discover zaprezentowano również bardziej szczegółowo technologie, które będą zastosowane w the Machine, włącznie z komponentami fotoniki krzemowej.

Na jednym ze stoisk można było zobaczyć narzędzie do emulacji służące inżynierom HP do opracowania firmware’u i systemu operacyjnego the Machine. Mimo, że samo urządzenie jeszcze nie istnieje, możliwe jest sprawdzenie jak funkcjonować będą ogromne zasoby pamięci, z których system będzie korzystał.

Narzędzie znane jako the Machine Architecture Simulator pozwala na symulowanie węzłów dla the Machine, dzięki czemu inżynierowie mogą wybierać pomiędzy procesorami typu x86 i ARM, co wskazuje na to, że maszyna będzie procesorowym agnostykiem.

Jak powiedział Fink, w rzeczywistości rodzaj procesora nie jest istotny. Duże firmy powinny móc projektować własne, dostosowane do aplikacji procesory, dołączać procesory graficzne lub karty interface’u sieci.

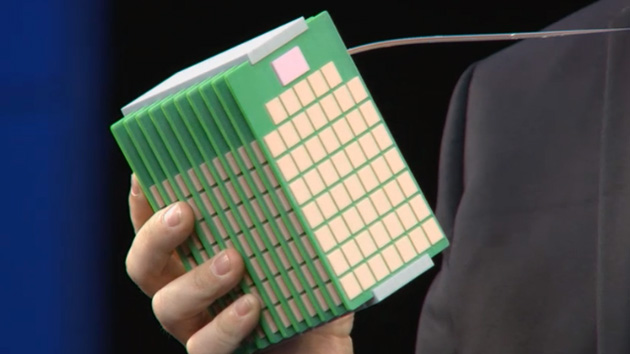

Inne stanowisko pokazywało model części the Machine – była to jednak niepracująca atrapa, przypominająca o tym, jak wiele pracy stoi jeszcze przed HP.

Produkt został dodany do zapytania.

Produkt został dodany do zapytania.