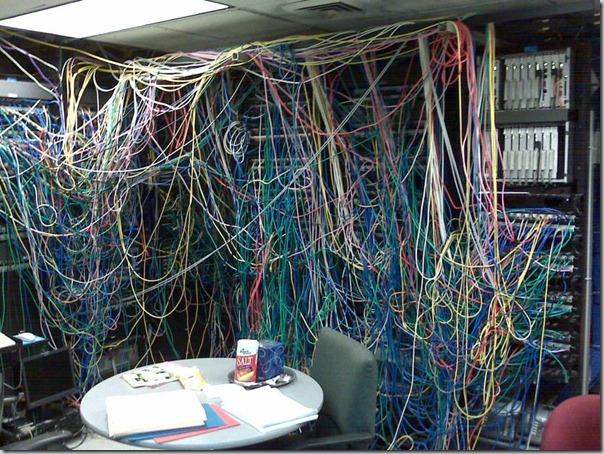

Serwerowe marnotrawstwo. Miliony bezczynnych maszyn na całym świecie.

Według danych umieszczonych w opublikowanym ostatnio raporcie około 30% serwerów operujących w ramach data center jest niewykorzystywanych, generując straty w kapitale infrastrukturalnym na poziomie 30 mld dolarów.

W sumie na całym świecie ok. 10 milionów serwerów znajduje się w stanie „śpiączki” oznaczającej brak działań obliczeniowych czy dostarczania informacji przez co najmniej 6 miesięcy. Taką analizę można znaleźć w raporcie Anthesis Group, zajmującej się doradztwem w zakresie zrównoważonego rozwoju.

Czerwcowy raport wykazał, że problem jest w zdecydowanie większym stopniu związany z niewłaściwym zarządzaniem i przepływem informacji niż z kwestiami technicznymi.

“W XXI wieku każda firma jest firmą IT, jednak zbyt wiele przedsiębiorstw daje przyzwolenie na znaczny brak efektywności infrastruktury informatycznej. Istnienie tak wielu uśpionych serwerów wyraźnie wskazuje na konieczność wprowadzenia zmian w sposobie projektowania, budowania, zabezpieczania i eksploatowania firmowych zasobów IT”.

Anthesis Group przeprowadziła badania we współpracy z Jonathanem Koomey’em, pracownikiem naukowym Stanford University, wykorzystując dane pochodzące od TSO Logic.

Wnioski płynące z raportu potwierdzają poprzednie badanie. Analizy dotyczące wykorzystania serwerów przeprowadzone przez McKinsey and Co. wykazały, że maszyny pracujące w ramach firmowych data center rzadko przekraczają 6% poziomu wykorzystania, a nawet 30% serwerów znajduje się w stanie uśpienia, pochłaniając energię elektryczną bez dostarczania jakichkolwiek informacji. Równolegle Uptime Instititute stwierdził, że aż 30% serwerów pracujących w Stanach Zjednoczonych jest niewykorzystywanych.

„Zdecydowanie zbyt wiele firm boryka się z problemem ogromnego braku wydajności infrastruktury informatycznej, często nieświadomie”, powiedział w oświadczeniu jeden z partnerów Anthesis, Jon Taylor. „Wyniki raportu powinny być pierwszym sygnałem dowodzącym, że optymalizacja wydajności, zużycia energii i poziomu zwrotu inwestycji może być zapewniona jedynie dzięki nieustannym pomiarom i dobremu zarządzaniu.”

Jak podaje raport, problem może okazać się bardzo kosztowny. Przy średnim koszcie serwera oscylującym na poziomie 3 tys. dolarów, 10 milionów bezczynnych maszyn (w tym 3,6 mln w USA) daje w sumie 30 mld dolarów zamrożonego kapitału, bez wliczania chociażby kosztów operacyjnych.

Według Koomey’a, usunięcie bezczynnych serwerów przyniosłoby ogromne oszczędności energii, która mogłaby następnie zostać wykorzystana przez maszyny niosące za sobą realną wartość dla biznesu. To rozwiązanie, któremu powinien kibicować każdy przedsiębiorca.

To, czego obecnie najbardziej brakuje firmom to umiejętność zidentyfikowania nieużywanego lub przesadnie zabezpieczonego sprzętu. Konwencjonalne narzędzia nie dają sobie rady z takim zadaniem.

“Zarządzanie zasobami poprzez proste pomiary poziomu wykorzystania procesorów i pamięci nie umożliwia pewnego wskazania uśpionego serwera”, twierdzą w raporcie przedstawiciele Anthesis Group. „Operujący data center powinni także obserwować ilość wysyłanych danych lub dostęp użytkownika do informacji w rozbiciu na serwer wykorzystując centralne zarządzanie, wirtualizację

i systemy dystrybucji obciążeń. Takie podejście pozwala na wskazanie urządzeń niewykonujących zadań kluczowych dla biznesu oraz ich usunięcie bez zagrożenia dla funkcjonowania przedsiębiorstwa.”

Według badaczy istnieje oprogramowanie mogące pomóc w wyeliminowaniu uśpionych urządzeń. Jedno z takich rozwiązań ma umożliwić wskazanie związku pomiędzy wysyłanymi do serwerów danymi a poziomem wykorzystania, wydajności i zużycia energii przez poszczególne maszyny. Wynikiem takich działań ma być określenie, które serwery nie przyjmują wysyłanych danych.

Produkt został dodany do zapytania.

Produkt został dodany do zapytania.